DataFocus Cloud如何连接本地数据库?

saas版本,我们可以借助DFCloudkit工具(附件可下载)来连接本地数据库。

DFCloudkit主要作用是连接DataFocus云应用和本地数据库,借助DFCloudkit工具可以将本地的CSV文件、Excel文件、MySql数据库、Micrsoft SQL Server数据库、Oracle数据库中的原始数据表导入DataFocus云应用,并且实现定时更新。

下面就一起来看下DFCloudkit小工具的使用教程吧:

一、工具参数配置

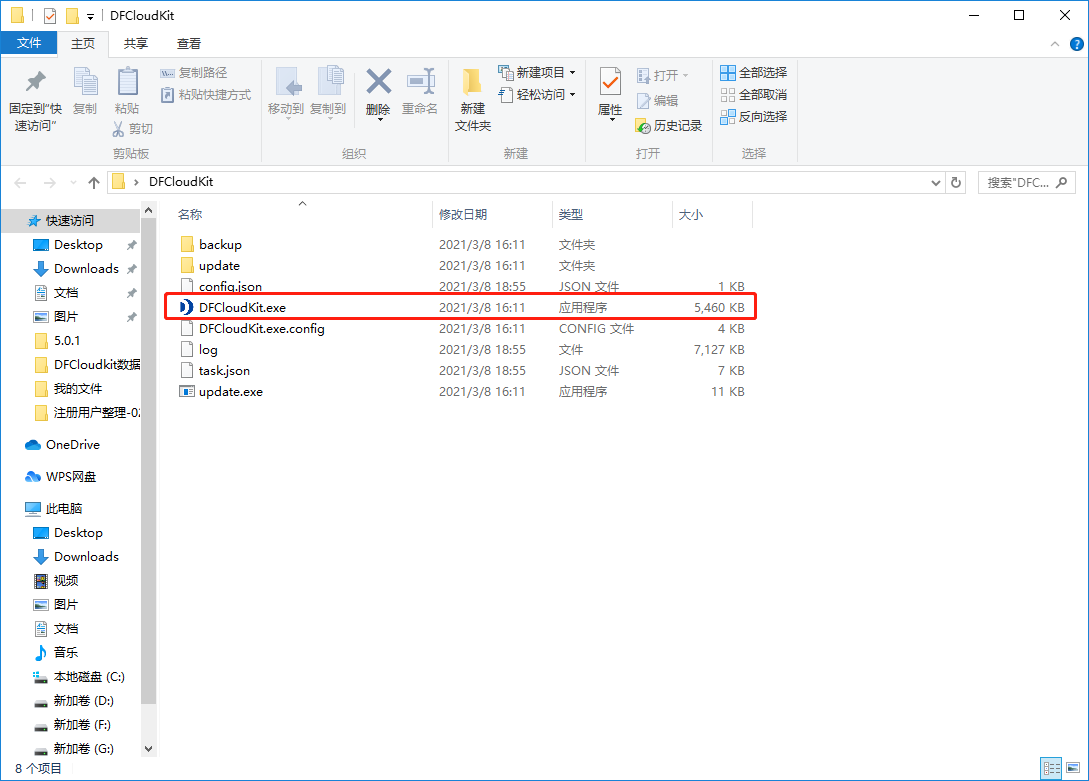

1、解压DFCloudkit小工具;

2、双击打开解压后的文件夹,选择如下图红框内框中的DFCloudkit应用程序,双击打开;

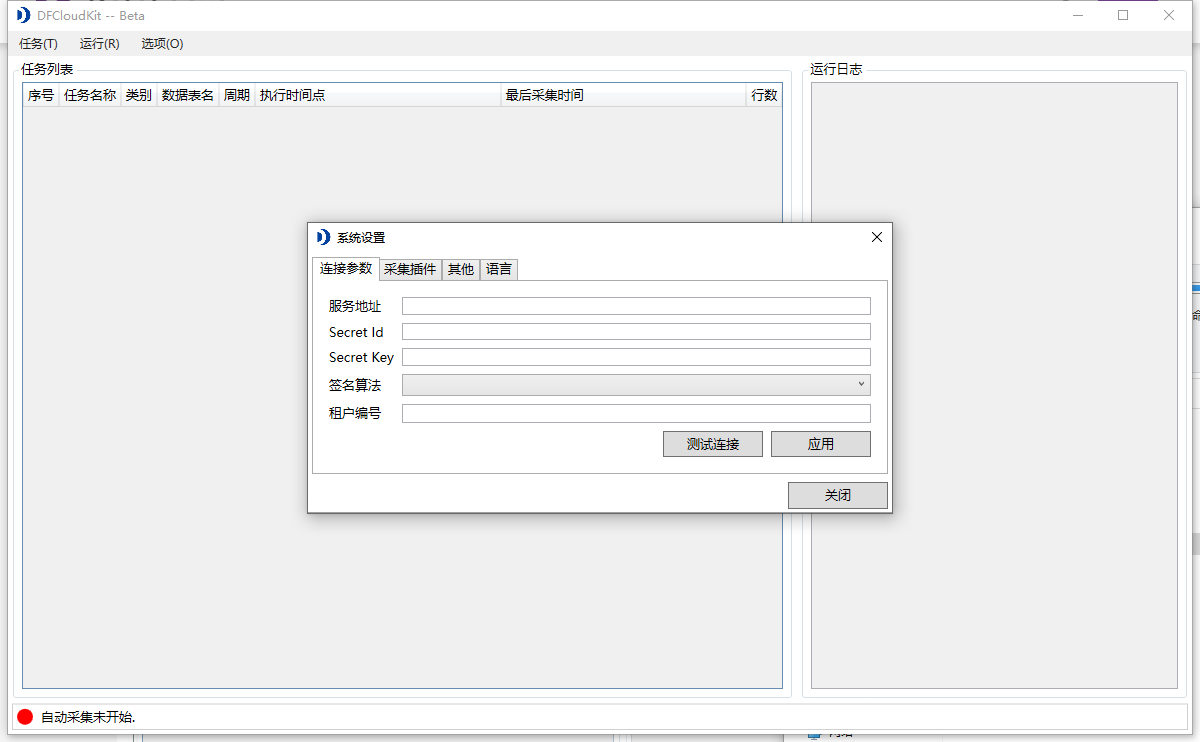

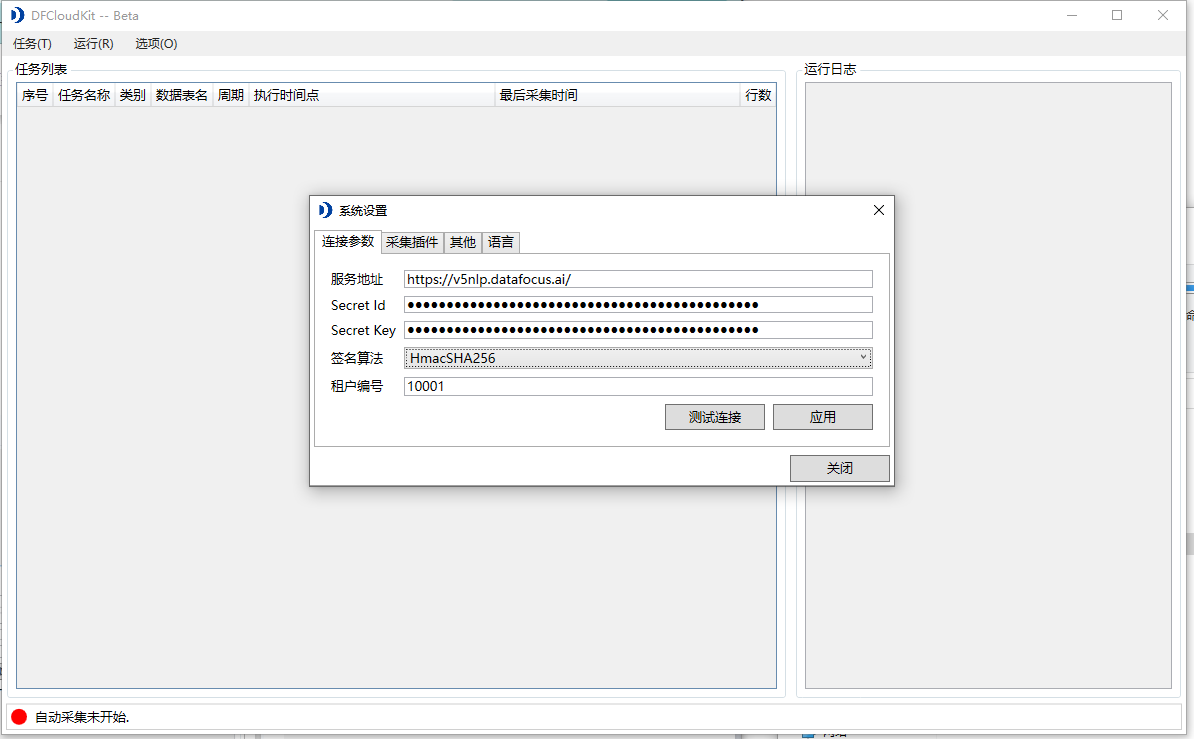

3、打开DFCloudkit工具,会弹出如下界面,系统会提示需要先进行服务连接参数设置;

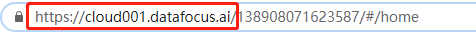

服务地址:就是DataFocus云应用的网址链接;

一般情况下企业共享版的服务地址都是:

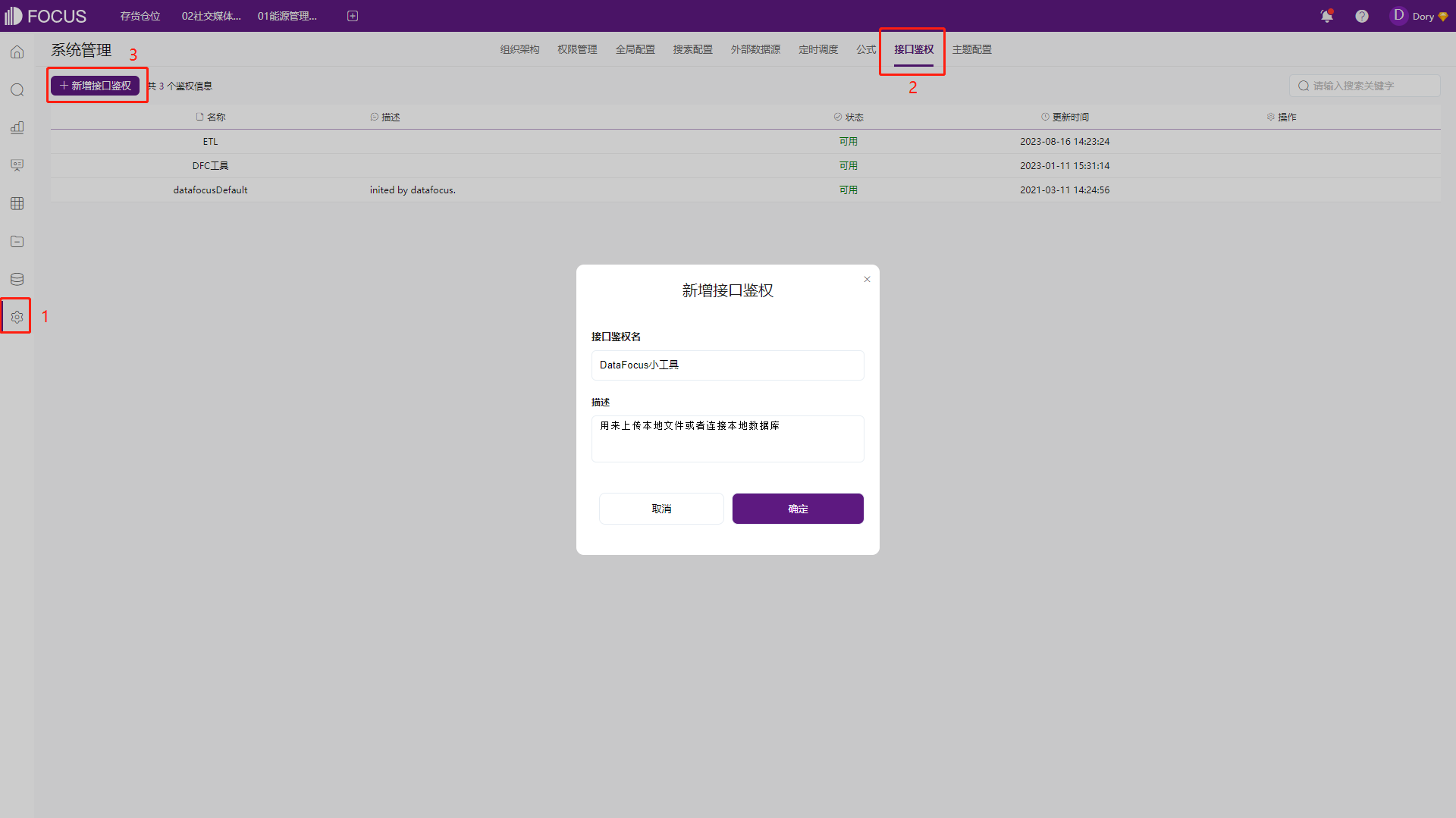

Secret Id和Secret Key:在DataFocus系统中可以生成(需要系统管理员的角色)

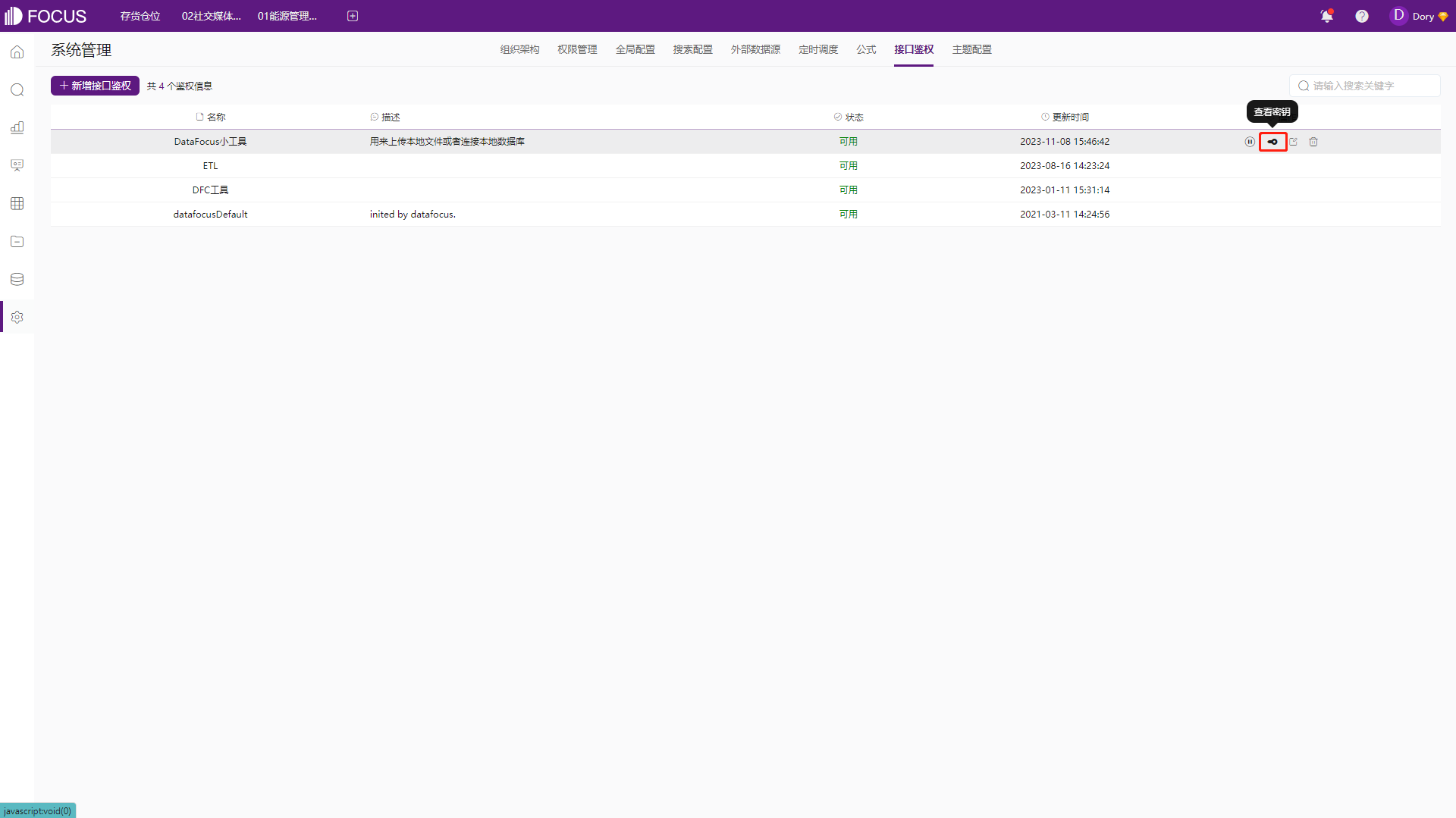

在系统管理模块,选择“接口鉴权”,点击“新增接口鉴权”,并填入相关信息;

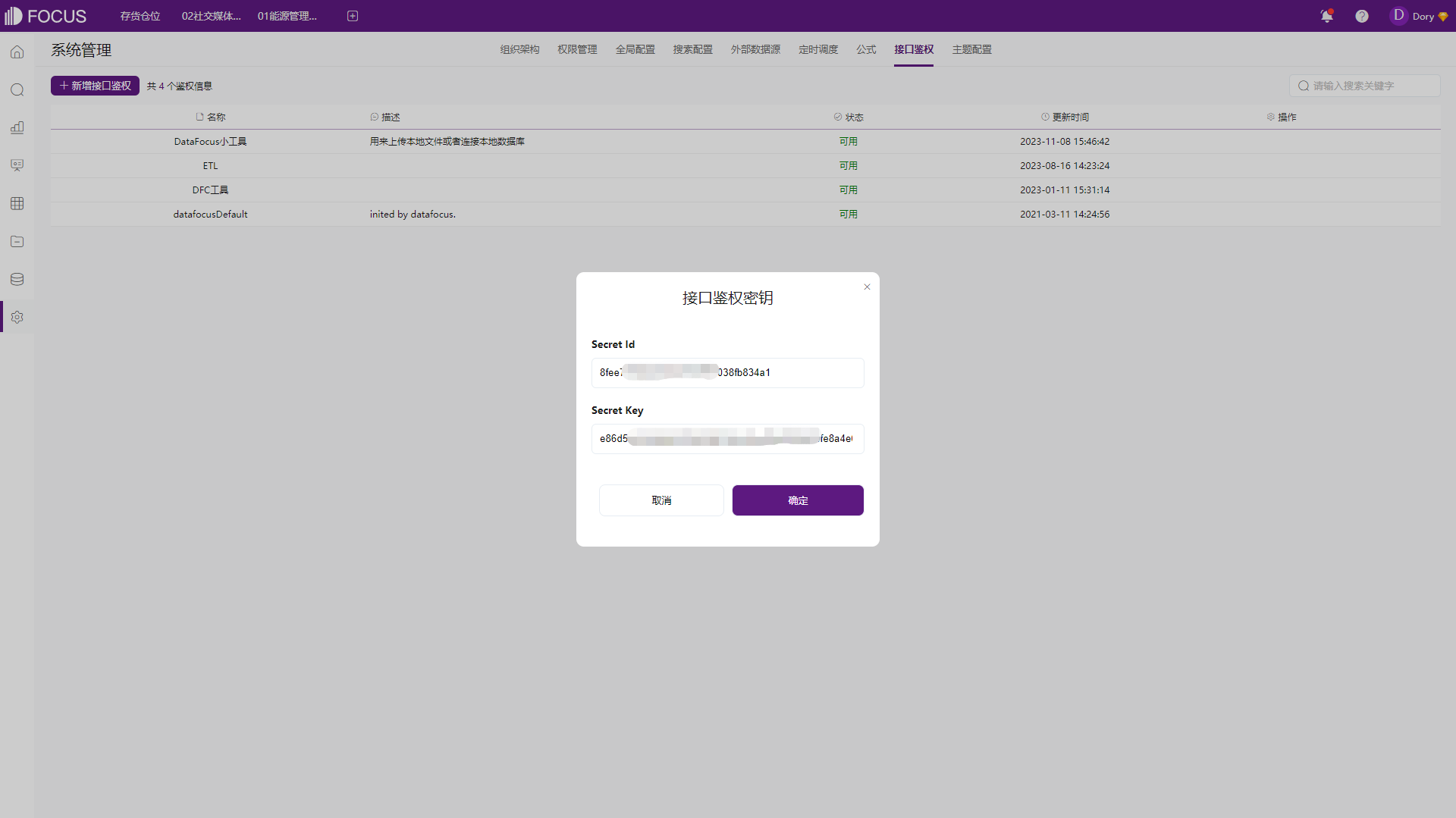

点击“确定”后,鼠标移到“操作栏”刚刚生成的那一条,并点击“查看密钥”;

之后把Secret Id和Secret Key填入小工具设置中;

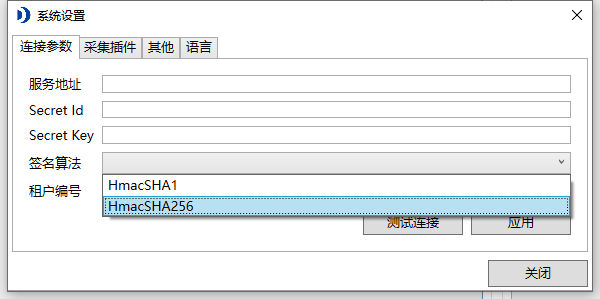

签名算法:选择“HmacSHA256”

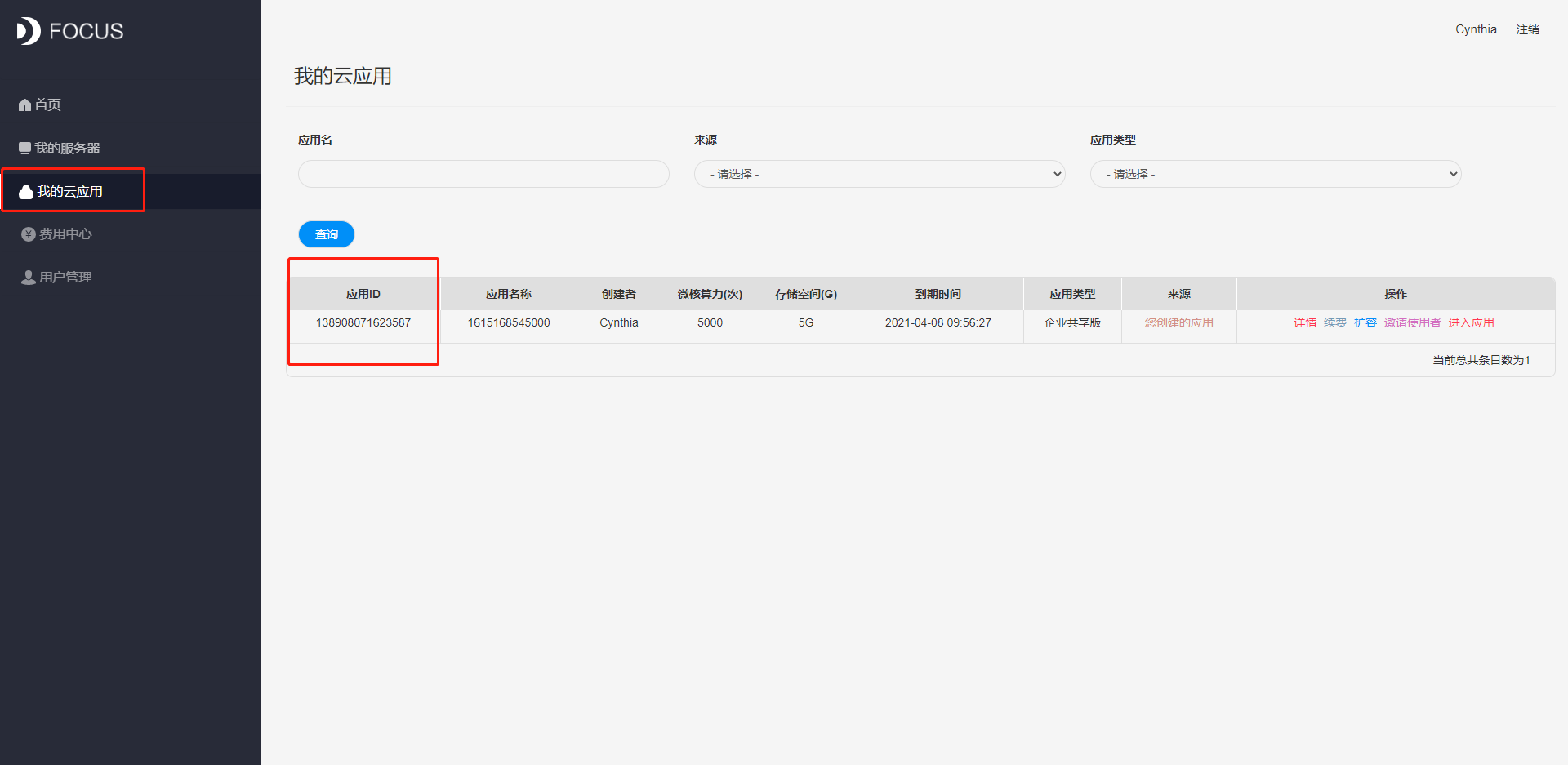

租户编号:用户创建的应用ID,可以在DataFocus控制台中我的云应用页面查看应用ID;

4、服务参数设置完成后,点击“测试并保存”;到此,DFCloudkit工具已经成功连接DataFocus云应用,接下来就可以新建任务,进行数据源导入了;

二、配置数据源

2、数据源可以选择本地的CSV文件、Excel文件、MySql数据库、Micrsoft SQL Server数据库、Oracle数据库;

3、这里我们以CSV文件和MySql数据库分别举两个例子;

—CSV文件

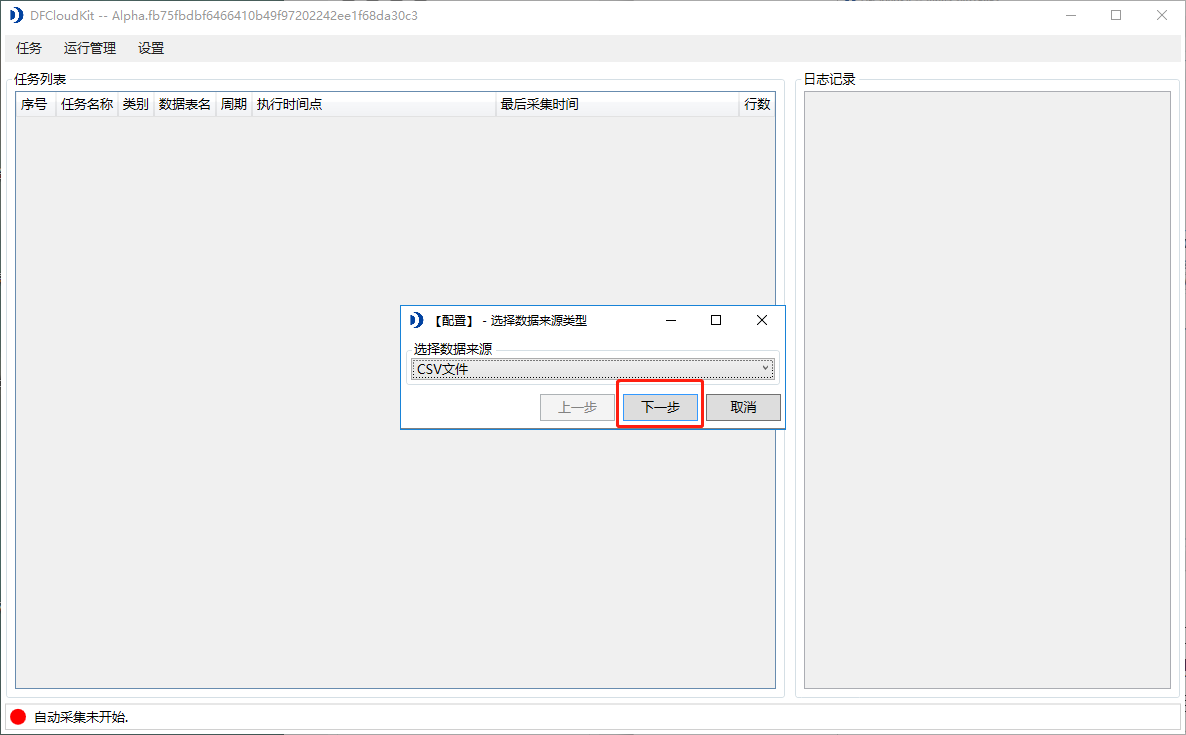

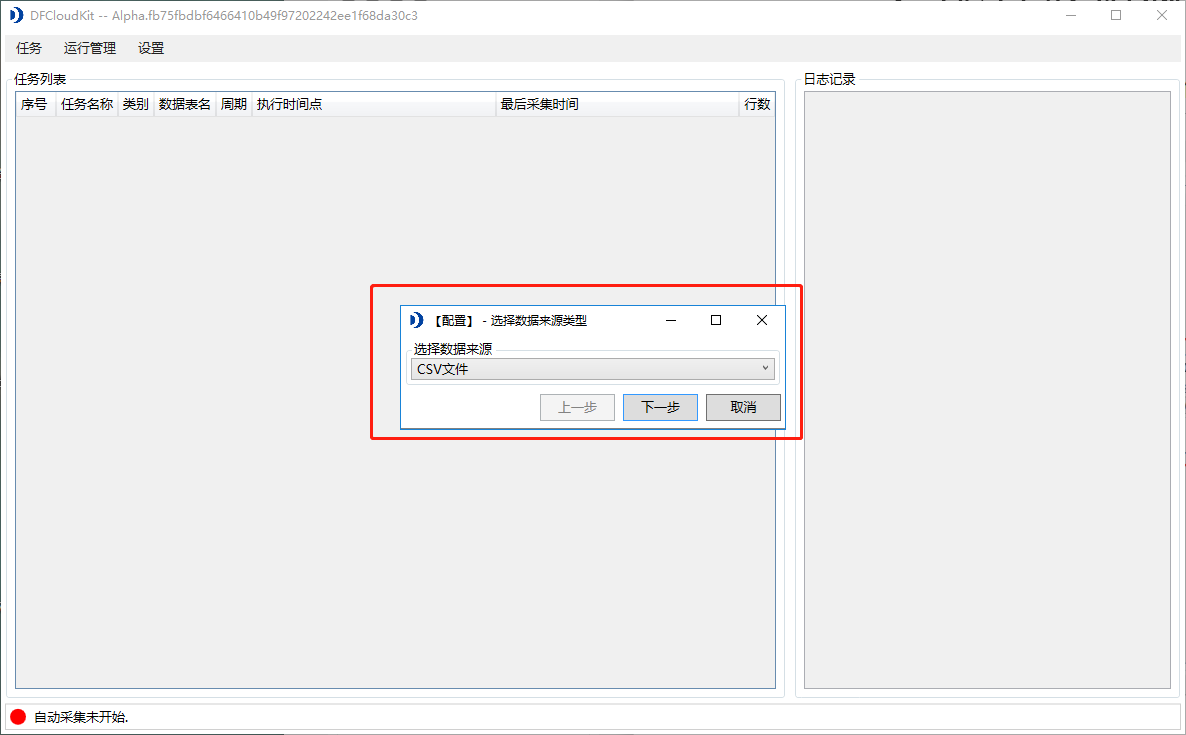

1)数据来源选择“CSV文件”后,点击下一步;

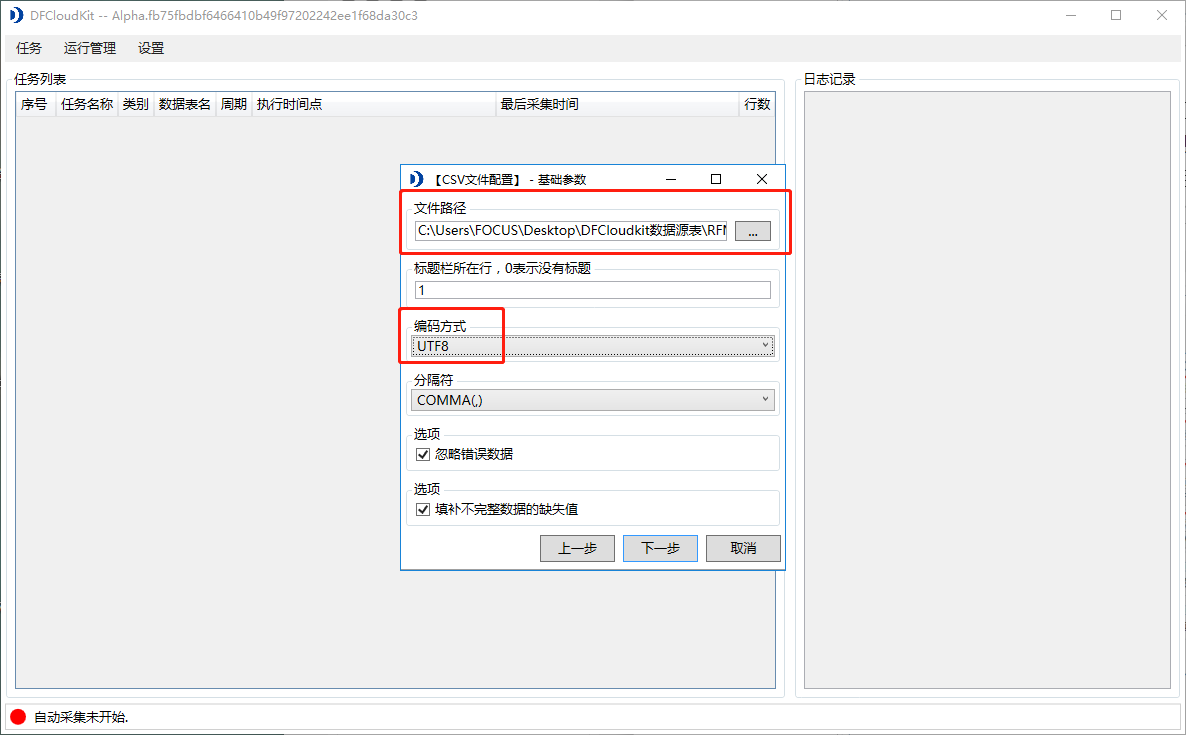

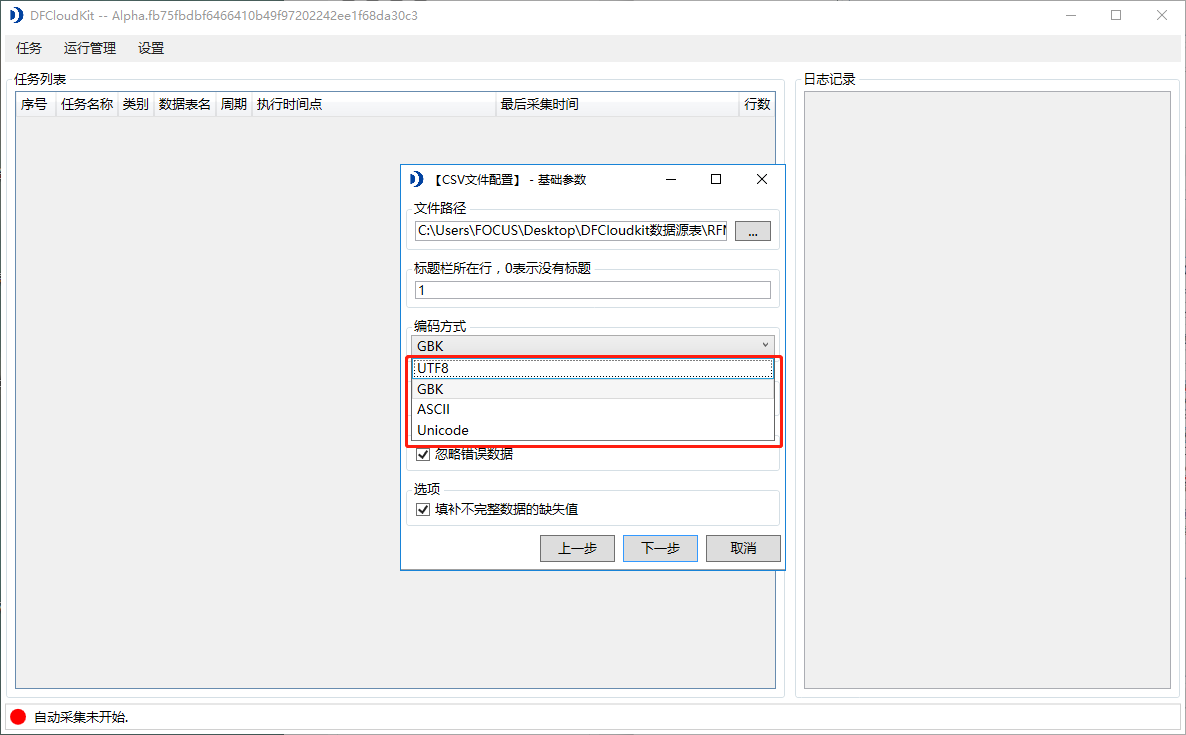

2)在弹出文件参数配置弹窗中,点击文件路径右侧的三点标志,配置需要导入的CSV文件路径;同时需要注意选择相对应的编码规则(一般情况下,编码规则选择:GBK),才能将导入文件中的中文正确显示,设置完成后点击下一步;

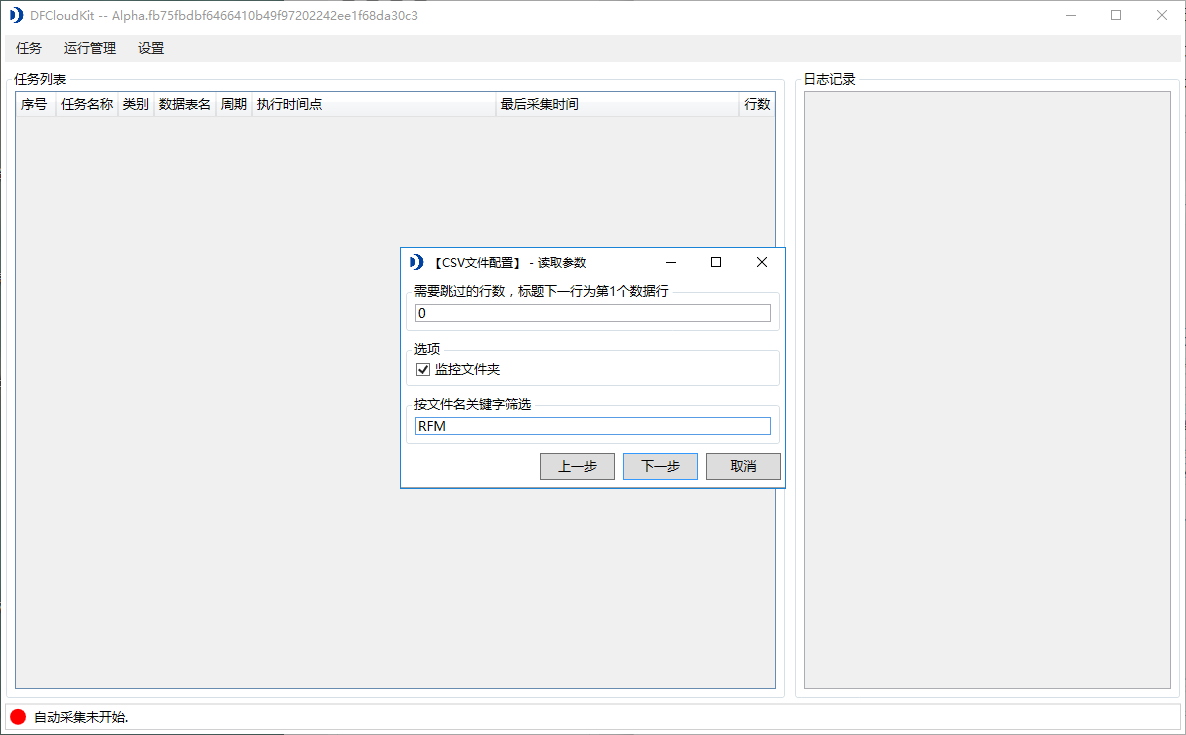

3)在弹出的“读取参数”弹窗中,可以对选中的文件夹进行监控:根据输入的筛选关键字,DFCloudkit工具会监控CSV文件所在的文件夹,文件夹中所有文件名符合筛选关键词的文件,都会进行导入,设置完成后点击下一步;

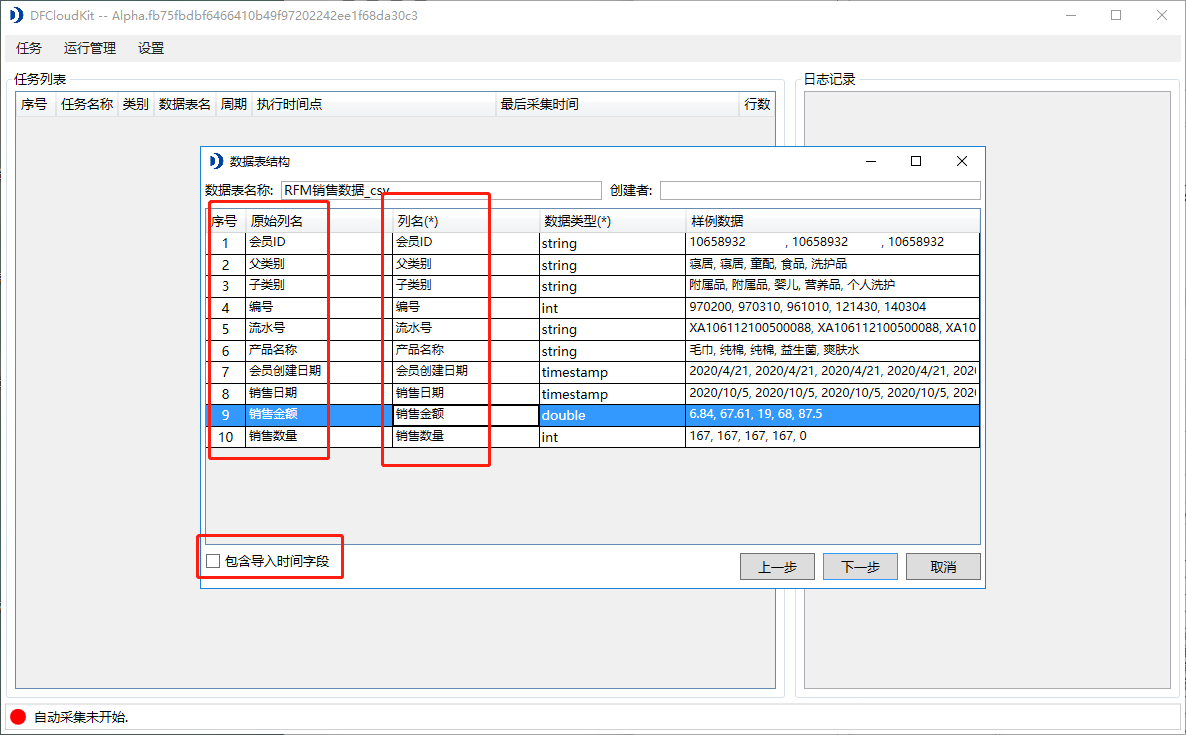

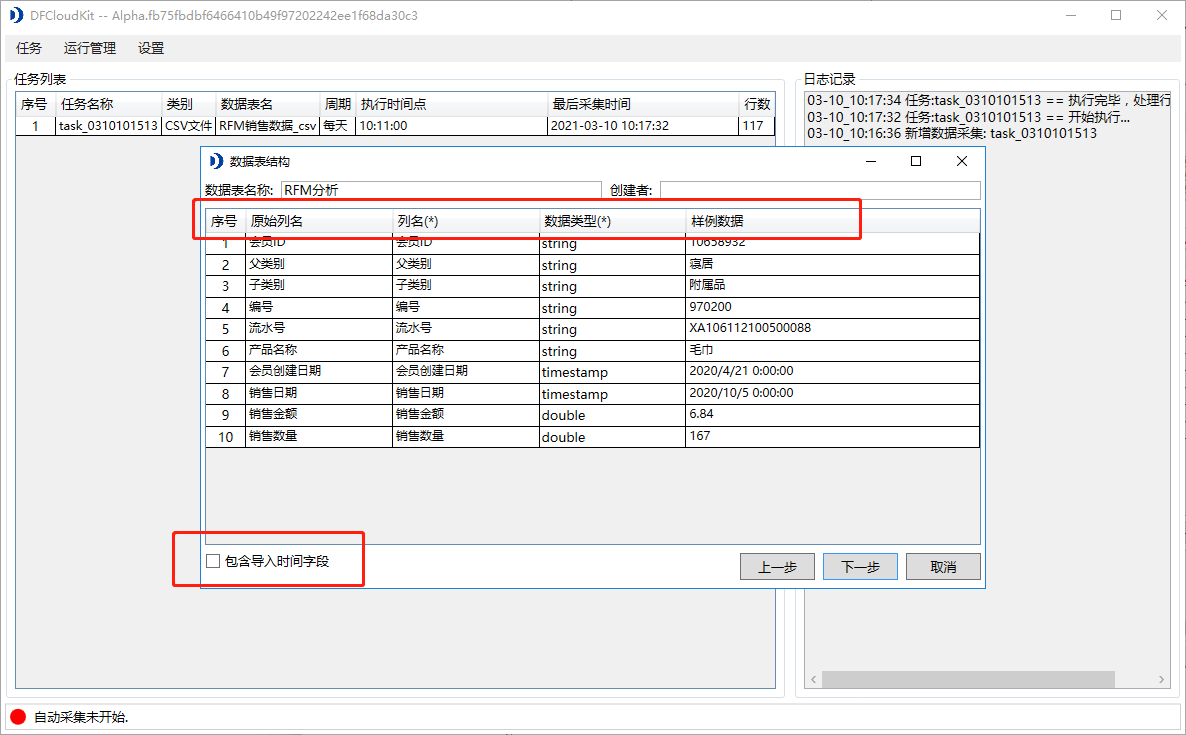

4)接下来进入数据表结构页面,在这个页面,可以看到导入的CSV文件的列名、数据类型和样例数据;

在这个页面,可以选择导入的列、重新命名表名及列名、修改列类型,还可以勾选是否“包含导入时间字段”,将当前导入时间作为单独一列生成并导入系统中,配置完成确认无误后点击下一步;

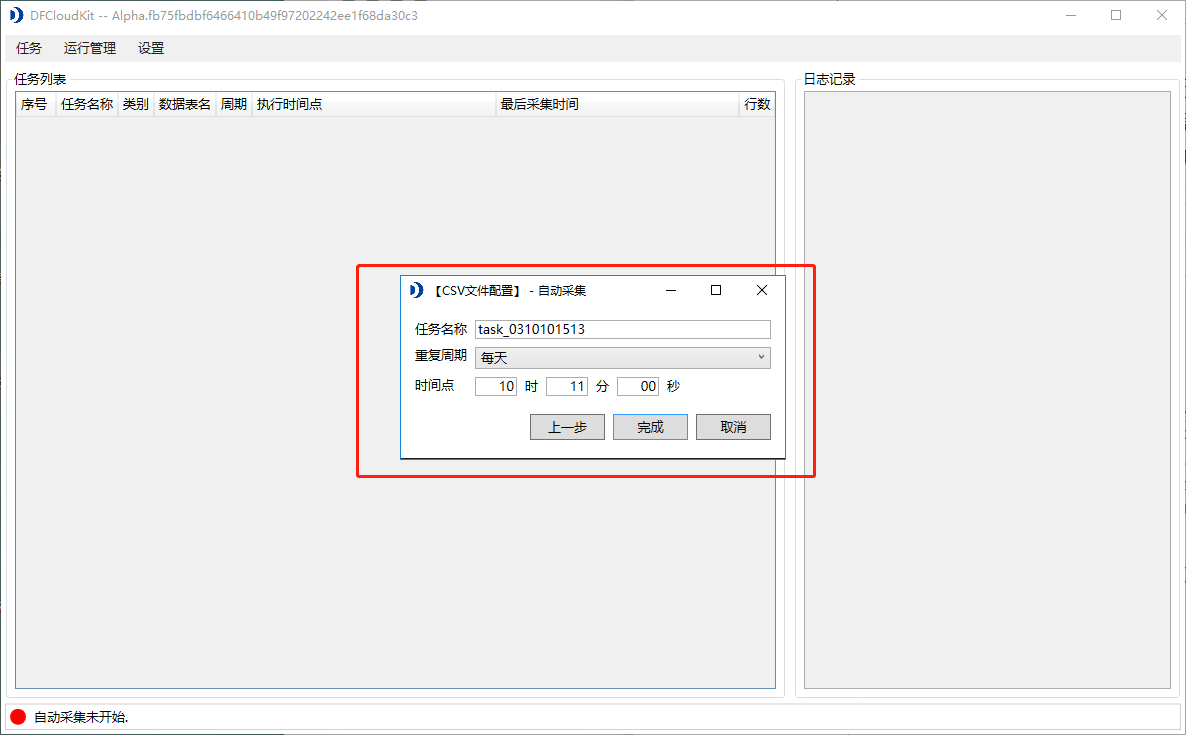

5)最后会弹出文件自动采集的时间配置,在这个页面中,可以为该数据导入的任务进行命名并设置系统自动动采集数据的重复周期,可以设置每小时、每天、每周和每月,同时配合时间点,固定一个自动采集的时间周期;

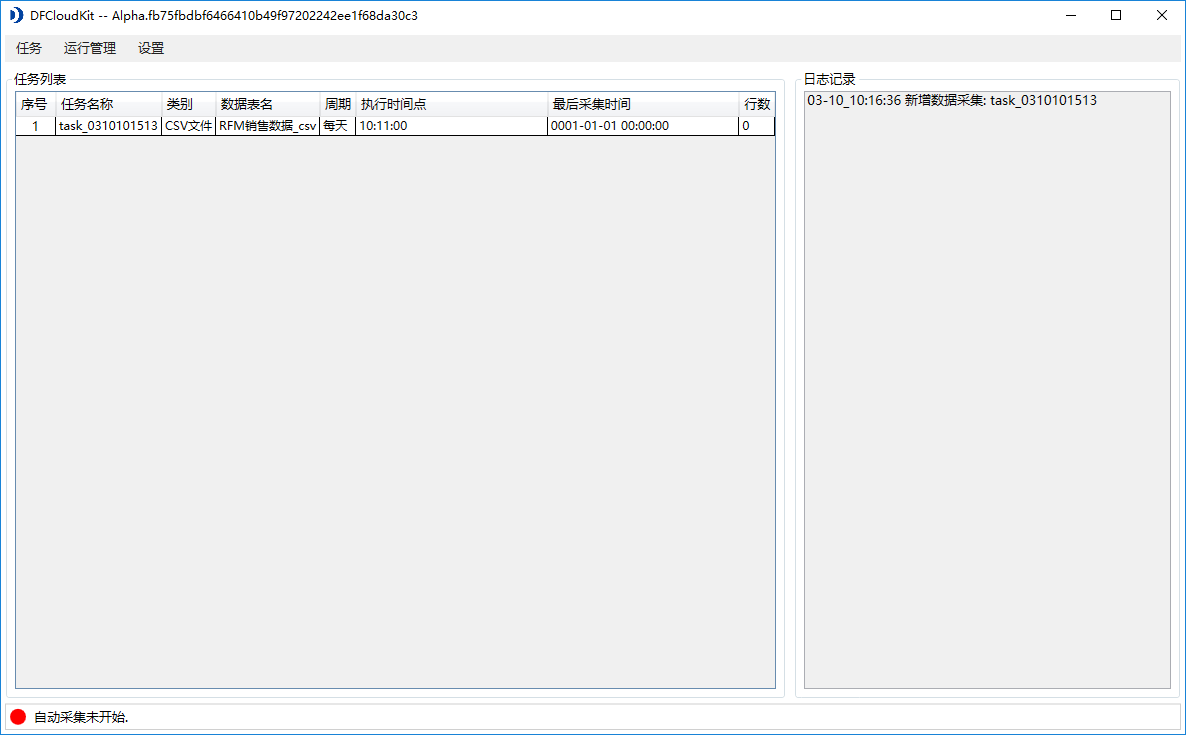

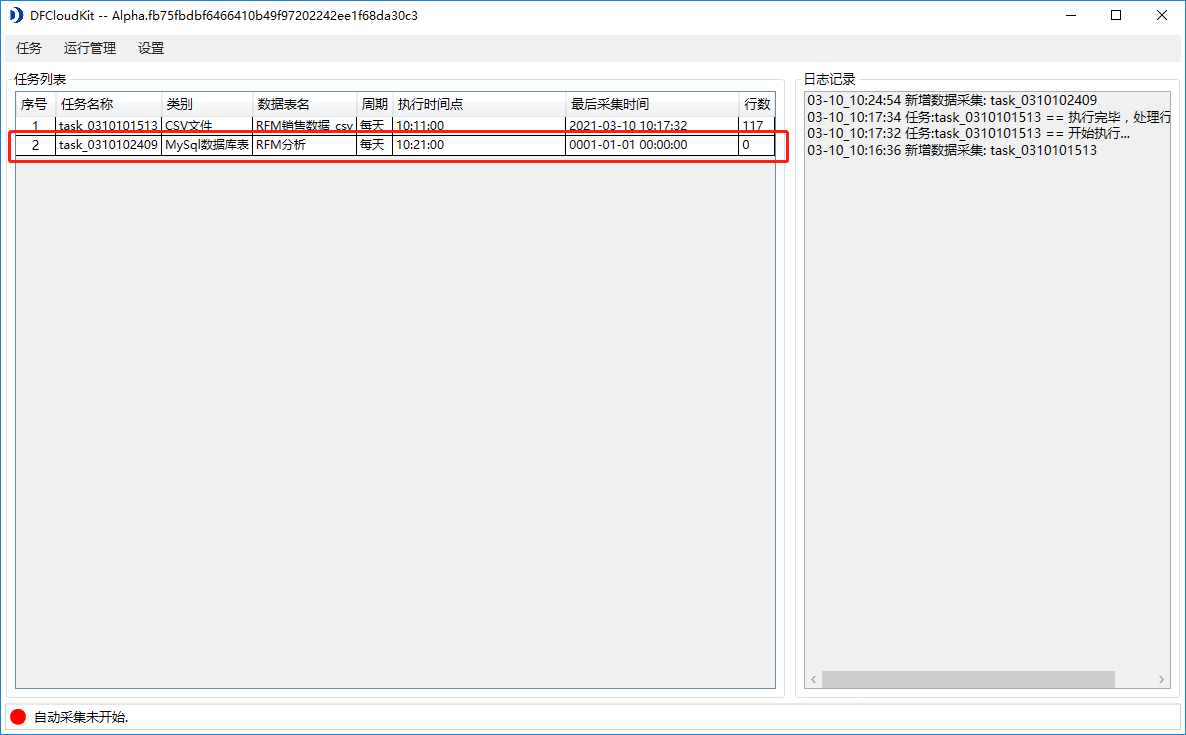

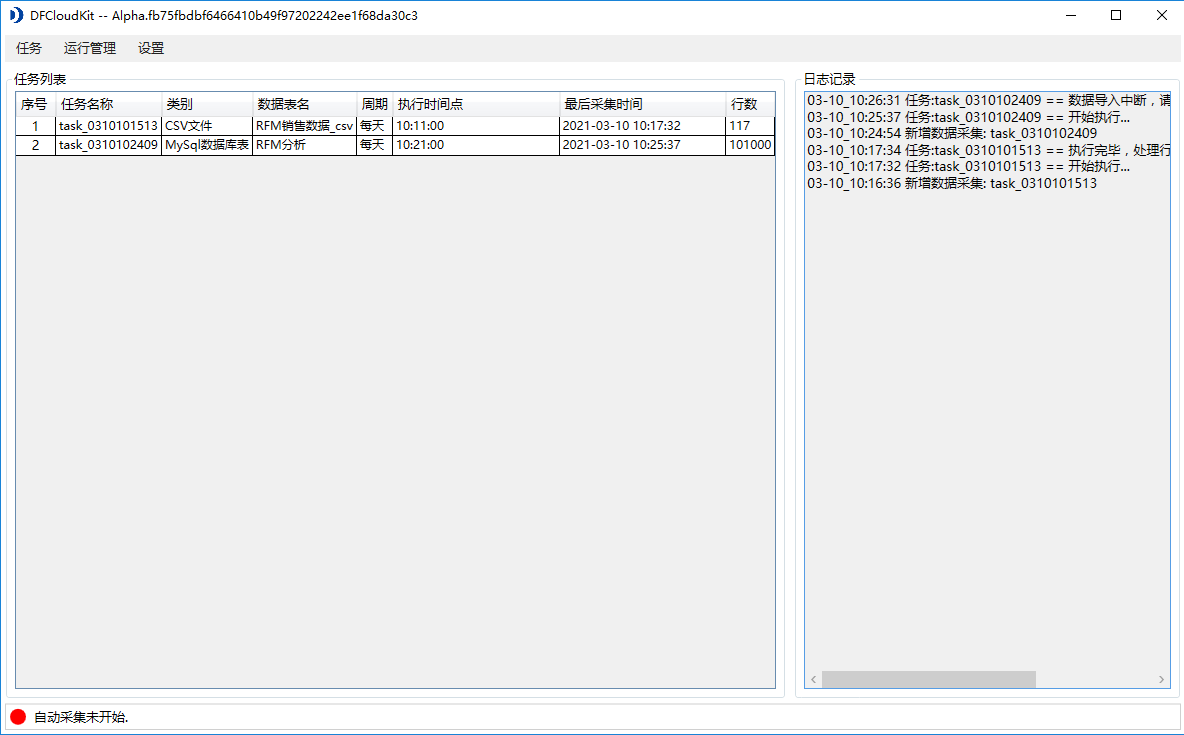

6)设置完毕后点击“完成”,此时会在任务列表中新增一条数据采集任务,该任务会按照设定的时间周期进行定时采集,若需要立即采集数据至DataFocus云应用,可以右键该任务,选择“立即同步”;

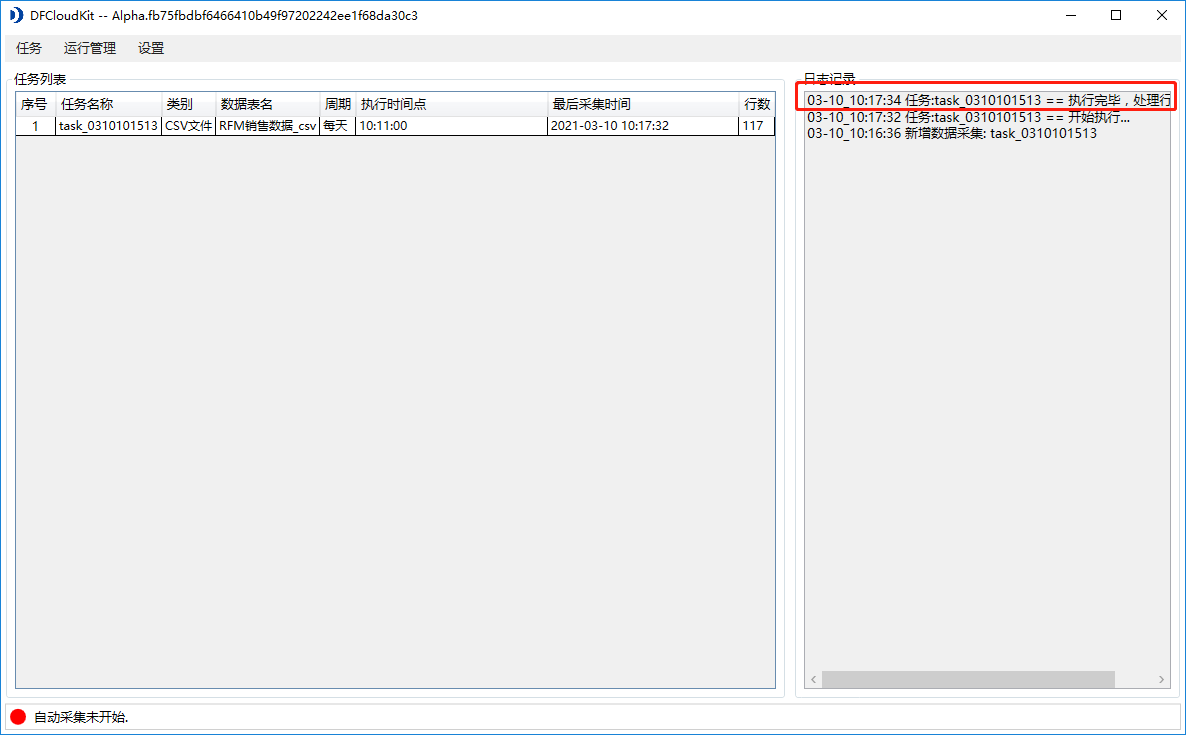

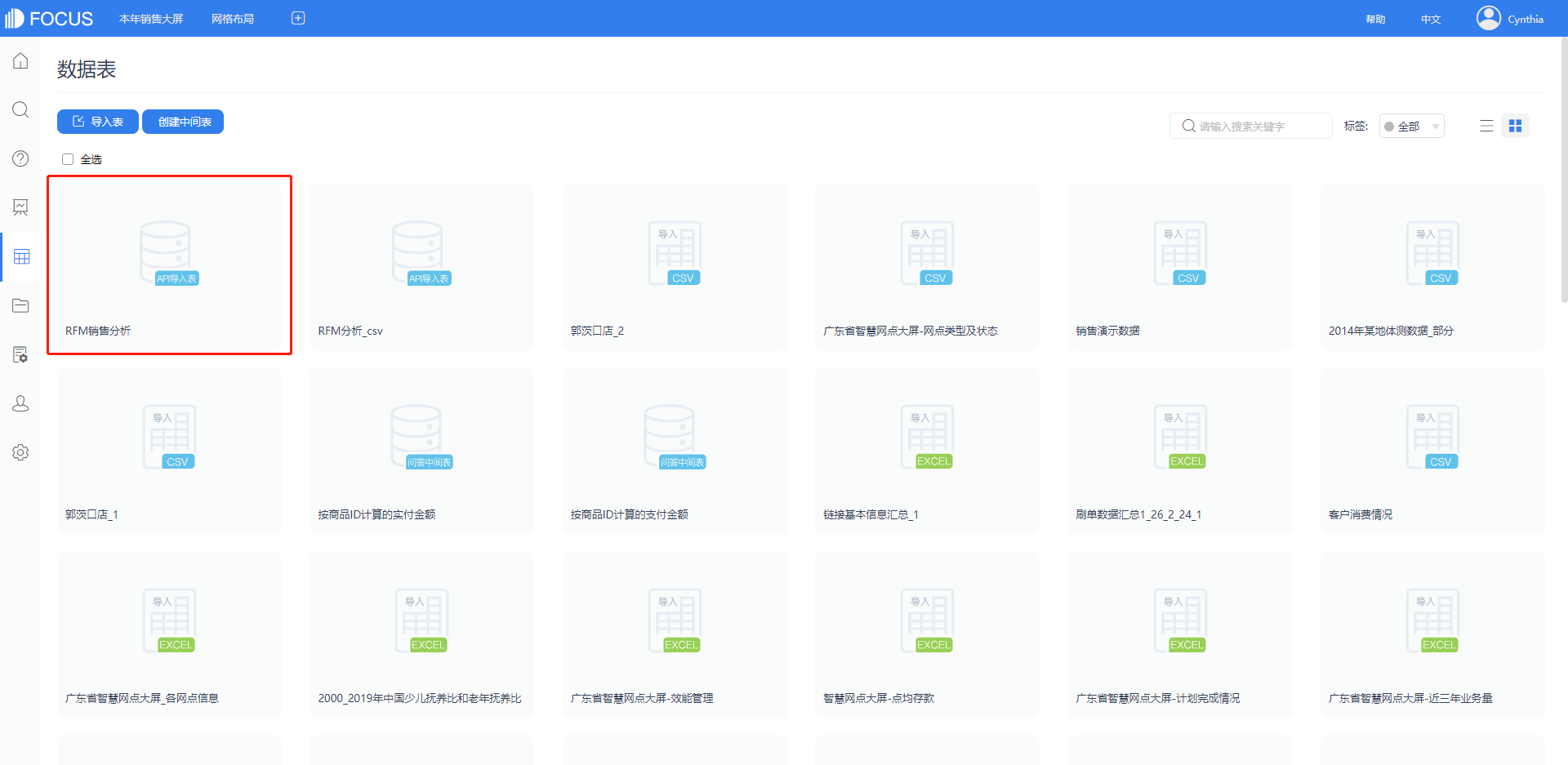

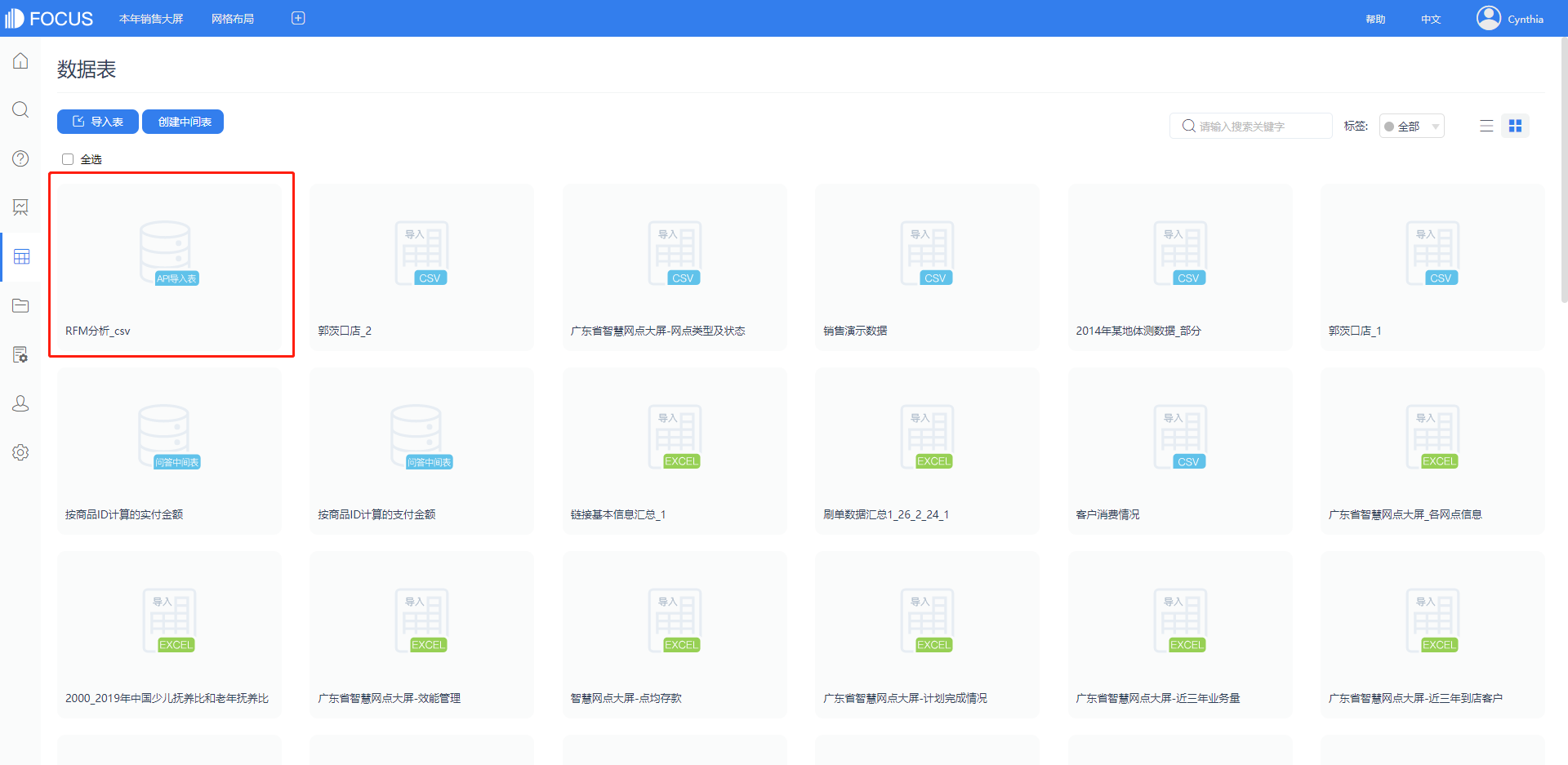

7)当日志记录中出现如下图所示的内容,说明CSV文件同步完成,DataFocus云应用中也会出现该CSV文件;

—mysql数据库

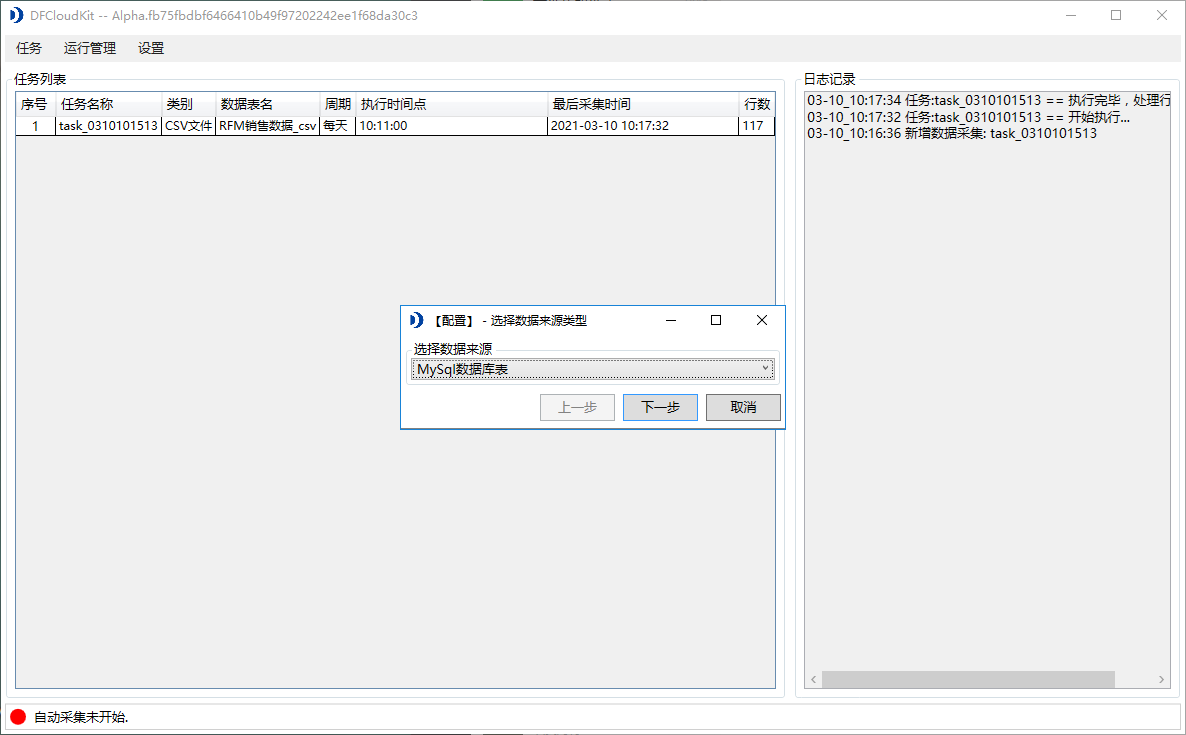

1)数据来源选择“MySql数据库表”后,点击下一步;

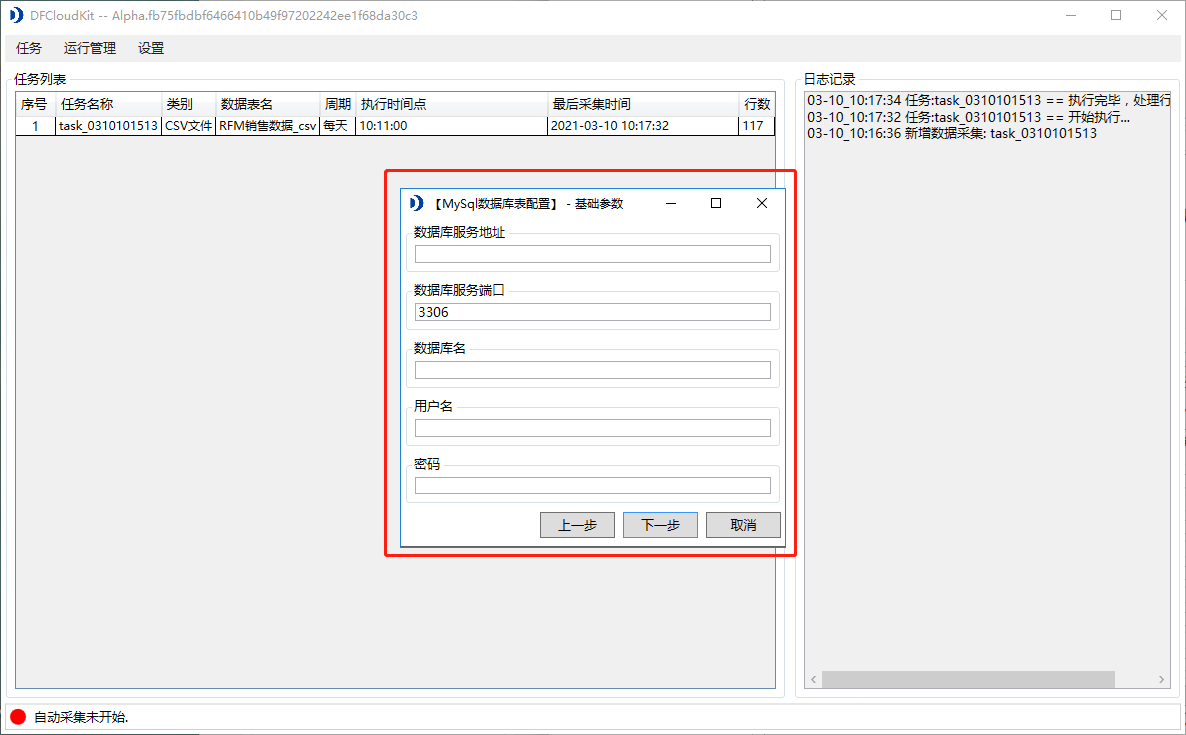

2)在弹出“基础参数”配置弹窗中,填写数据库服务地址、数据库服务端口、数据库名、用户名和密码,配置完成后点击下一步;

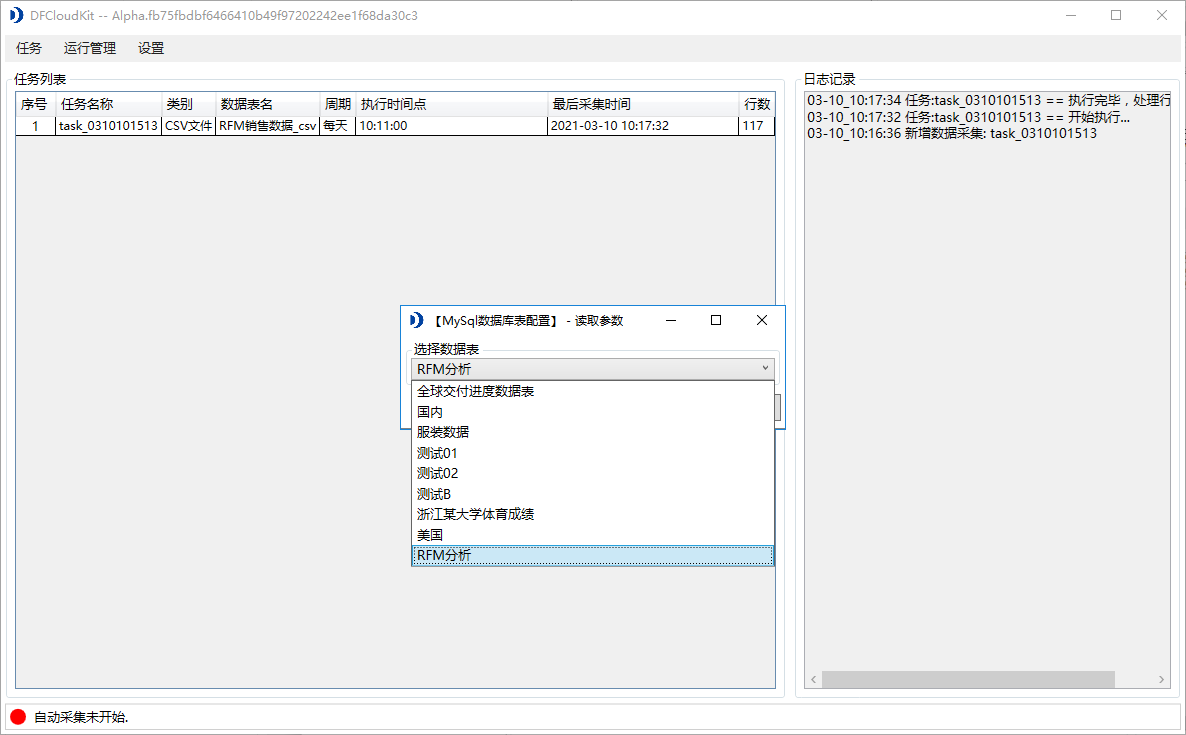

3)在弹出的“读取参数”弹窗中,选择需要导入的数据表,完成后点击下一步;

4)接下来同样是进入“数据表结构”页面,该页面操作和CSV文件导入一致,这里就不重复了;点击下一步;

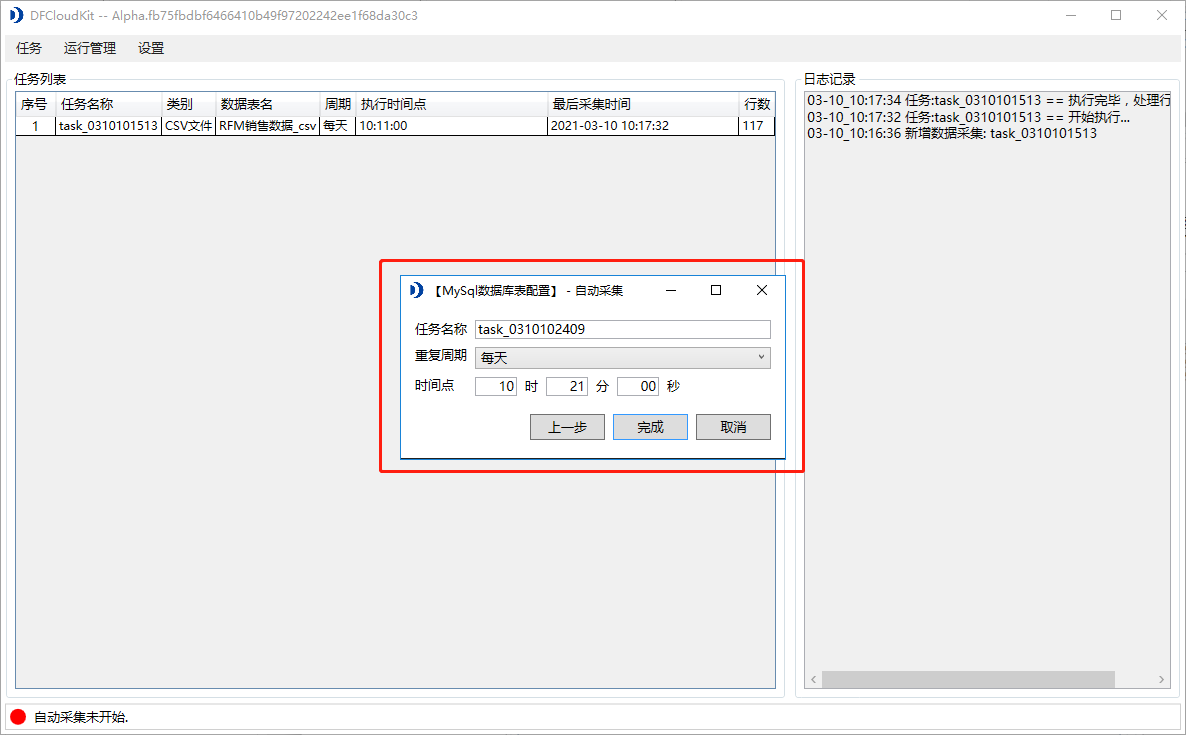

5)最后弹出的也是文件自动采集的时间配置,同样是配置该采集任务的重复周期时间点;

6)设置完毕后点击“完成”,任务列表同样会新增一条采集任务,可以右键该任务,选择立即同步;

7)当日志记录中出现如下图所示的内容,说明MySql数据库表同步完成,DataFocus云应用中也会出现该表格文件;(数据量较大需要分批次进行同步,后续会放开限制)

三、工具下载

工具下载后,请将压缩包解压到当前文件夹

全部 0条评论